プログラミング

プログラミング __cplusplus について

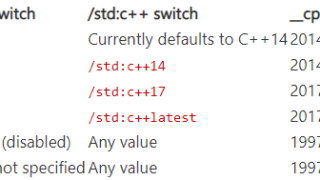

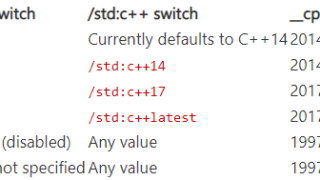

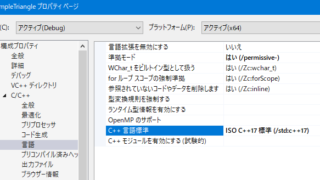

C++を使っていて、C のコードブロックを書きたいときに __cplusplus を使用して対処することがあります。 このとき、 __cplusplus が定義されていたら、現在は C++ のコンテキストでコンパイルしている、と判断していたわけですが、この __cplusplus は実はC++のバージョン値を持っていたということを今更知りました。 きっかけは...

プログラミング

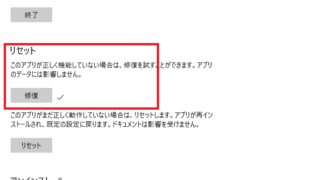

プログラミング  PC環境設定

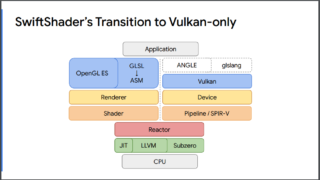

PC環境設定  Vulkan

Vulkan  プログラミング

プログラミング  Vulkan

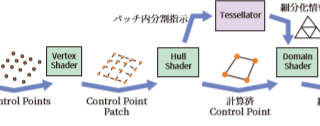

Vulkan  DirectX

DirectX  日記

日記  DirectX

DirectX  PC環境設定

PC環境設定  DirectX

DirectX